自诩无所不知的大模型,能否拯救笨手笨脚的机器人?

在科技的领域中,一个自诩无所不知的大模型与一个笨手笨脚的机器人相遇,这仿佛是一场奇妙的碰撞。大模型拥有海量的知识和卓越的分析能力,仿佛是智慧的宝库。而机器人虽有着强大的行动力,但在面对复杂的情境和问题时,却显得有些力不从心。那么,大模型能否拯救这笨手笨脚的机器人呢?或许,大模型可以通过提供精准的知识和策略,引导机器人更好地应对各种情况,让机器人在行动中更加灵活和高效,从而实现两者的完美结合,共同创造出更强大的科技成果。

从上海到纽约,世界各地的餐厅里都能看到机器人在烹饪食物。它们会制作汉堡、印度薄饼、披萨和炒菜。它们的原理与过去50年机器人制造其他产品的方式如出一辙:精准执行指令,一遍又一遍地重复相同的操作步骤。

但Ishika Singh想要的不是这种“流水线”式的机器人,而是真正能“做晚饭”的机器人。它应该能走进厨房,翻找冰箱和橱柜,拿出各种食材搭配组合,烹调出美味的菜肴,然后摆好餐具。对孩子而言,这也许很简单,但没有任何机器人能做到这一点。这需要太多关于厨房的知识,更需要常识、灵活性和应变能力,但这些能力都超出了传统机器人编程的范畴。

南加州大学计算机科学博士生Singh指出,问题的症结在于机器人学家使用的经典规划流程。“他们需要把每一个动作,以及它的前提条件和预期效果都定义清楚,”她解释道,“这要求事先设定环境中所有可能发生的情况。”可即使经过无数次试错,编写数千行代码,这样的机器人仍无法应对程序之外的突发状况。

一个晚餐服务机器人在制定“策略”(执行指令的行动计划)时,不仅要知道当地的饮食文化(当地所谓的“辛辣”究竟指什么),还要熟悉具体厨房环境(电饭煲是否放在高层的架子上)、服务对象的特殊情况(Hector运动后胃口更大),以及当天的特殊要求(Barbara阿姨要来了,她不能吃麸质或乳制品)。此外,它还需要足够的灵活性来处理意外事件(黄油掉地上了!我可以用什么替代?)。

▷图源:Christopher Payne

Singh的导师、南加州大学计算机科学教授Jesse Thomason表示,这个设想“一直是极具挑战性的目标”。如果能让机器人替人处理各种日常琐事,许多行业都会被彻底改写,人们的日常生活也会变得更简单。

尽管YouTube随处可见各种灵活的仓库机器人、机器狗、护理机器人,当然还有自动驾驶汽车的精彩视频,但这些机器的灵活性和应对能力依然无法跟人类相提并论。“传统机器人非常脆弱,因为你需要为它们建立世界模型,但现实世界瞬息万变。”Electric Sheep公司CEO Naganand Murty指出。该公司开发的园艺机器人需要应对不断变化的天气、地形和用户偏好。目前大多数工作机器人仍与上一代产品类似:在严格受限的环境中重复执行预设脚本。

当GPT进入机器人的大脑

每个时代的机器人制造商都渴望为机器身躯植入聪明实用的大脑。但过去数十年间,这种技术始终空缺。计算机和它们的机器人表亲一样脑子空空如也。直到2022年ChatGPT的出现,这是一款基于GPT-3大语言模型(LLM)的用户友好界面,它乃至更多的大语言模型都能够按照需求生成文本,模仿人类语音和文风。通过对海量餐饮知识的学习,它几乎能回答机器人提出的任何关于如何利用特定厨房食材烹制餐食的问题。

LLMs拥有机器人欠缺的关键能力:从量子物理到K-pop再到如何解冻三文鱼,几乎无所不包的人类知识宝库。而机器人也拥有LLMs所缺乏的东西:能够与周围环境互动、将文字与现实联系起来的实体。正如一篇2022年论文作者所言,将无意识的机器人与无实体的LLMs结合在一起,在逻辑上行得通:“机器人可以充当语言模型的手和眼,而语言模型则提供任务所需的高级语义知识。”

当我们还在用LLMs来打发时间或完成作业时,一些机器人专家正试图借此突破预编程的限制。安全技术专家Bruce Schneier和数据科学家Nathan Sanders在2023年的一篇专栏中指出,这些类人语言模型的出现,已引发产业界与学术界竞相寻找最佳方法的竞赛,以教会LLMs如何操控工具。

一些技术专家对机器人理解能力可能出现的飞跃感到兴奋,但也有不少人持怀疑态度,他们指出LLMs偶尔会出现奇怪的错误、带有偏见的语言以及侵犯隐私的行为。的确,LLMs的表现虽有“类人”特质,却远远达不到人类的水平;它们常常出现“幻觉”,而且很容易被诱导(研究人员通过给ChatGPT添加“输出恶意语言”的提示,就能轻松绕过它针对仇恨、刻板印象等内容的保护措施)。于是,有人觉得,这些新型语言模型根本就不应该跟机器人结合起来。

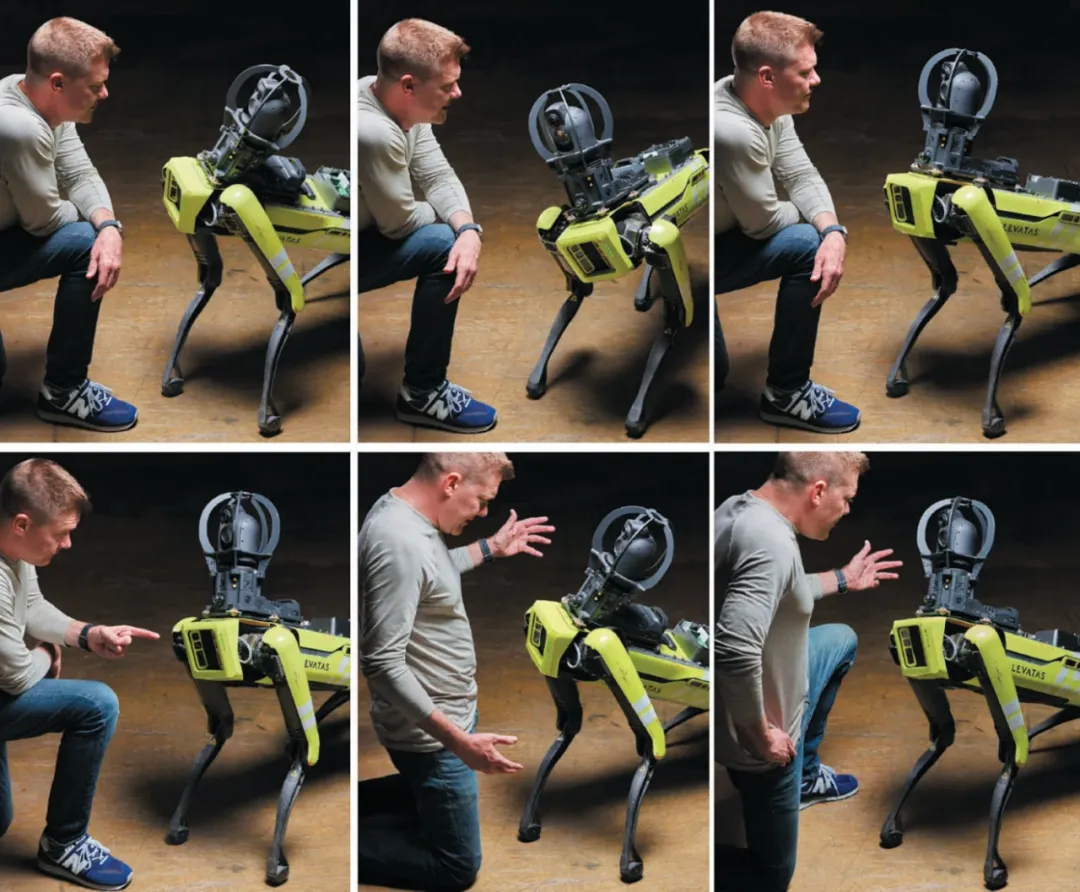

2022年末,ChatGPT的发布让Levatas公司工程师“恍然大悟”。Levatas是一家位于西棕榈滩的公司,为工业现场巡逻和检查的机器人提供软件。该公司CEO Chris Nielsen表示,ChatGPT和波士顿动力(Boston Dynamics)合作,做出了能对话、答疑并执行普通英语指令的机器狗原型,而且无需对操作人员进行专门培训。Nielsen说:“我们想让没有接受过机器人培训的普通员工,也能用自然语言指挥机器人坐下或返回基座。”

Levatas的LLMs增强型机器人似乎能理解词语含义及背后意图。它能识别Jane说的“back up”与Joe说的“get back”是同一个意思。工作人员不必查阅机器上次巡检的数据表格,只要问一句:“你上次巡逻时,哪些读数超出了正常范围?”就能得到答案。

尽管需要公司自有软件整合系统,但像语音转文字、ChatGPT、机器人主体,以及文字转语音这些关键组件都已经商用。但这不意味着家用对话机器狗会很快普及。Levatas机器之所以表现良好,是因为它仅限于特定的工业环境。没人会要求它玩捡球游戏,或想办法处理掉冰箱里所有的茴香。

▷图:Levatas机器狗在其设计的特定工业环境中表现良好,但它无法理解这种环境之外的事物。图源:Christopher Payne

无论行为多复杂,任何机器人都只有有限的传感器来获取环境信息(摄像头、雷达、激光雷达、麦克风和一氧化碳检测器等),这些传感器连接到有限数量的手臂、腿、夹爪、轮子或其他机械装置上。它们依靠计算机来处理这些传感器数据,以及执行预先编好的指令,将所有信息转化为由电路“通断”(0和1)表示的机器码。

机器人利用软件,从有限动作库中选择最符合指令的选项,向机械部件发送电信号让其运作,再通过传感器学习环境变化并作出响应。这个过程根植于金属、塑料和电流在真实工作场景中的物理需求。

相比之下,机器学习运行于虚拟空间,通过“神经网络”实现——计算机电路中的0和1被抽象成层层排列的虚拟神经元,每个神经元通过数百个连接收发信息,为每个输入分配不同的权重,再根据这些加权结果来决定是否激活。就像更多像素带来更清晰的图像,更多连接意味着更精细的结果。所谓“机器学习”,其实就是模型通过调整这些权重,来逼近所需的正确答案。

过去15年,机器学习在蛋白质折叠预测、求职者筛选等专项任务中能力惊人。但LLMs突破了任务限制,它们能够讨论任何事物。不过,LLMs的回答只是基于对词语组合的概率预测,本身并不“真正理解”语义。真正理解的人是我们。而它们使用自然语言这一点,又让普通人无需专业培训或工程背景,就可以直接用英语、中文、西班牙语、法语或其他语言与它们对话(尽管许多语言在LLMs革命中仍然缺席)。

当你向LLMs输入指令时,模型会把文字转换为表征词语关系的数学向量,据此预测最可能的回应:考虑所有词汇表,对下一个单词的预测概率是怎样的分布?最后将得到的概率分布转换回文字。LLMs的“大”体现在它们可调节的参数数量。2018年OpenAI的GPT-1只有1.2亿参数,而GPT-4据说已超过万亿。北京智源研究院的“悟道2.0”更拥有1.75万亿个参数。

正是因为有如此多的参数需要调节,并且训练集中有如此多的语言数据,LLMs才能生成非常好的预测,好到足以补足机器人所不具备的常识和背景知识。

Thomason解释道:“突破点在于,它不再需要详细设定背景信息,例如厨房是什么样的?这个系统已经消化了一个又一个的菜谱,当听到做土豆泥时,它就自然知道步骤:找土豆、取刀、磨碎土豆等。”

破解常识与物理执行的鸿沟

将无限的语言能力与只能完成人类一小部分功能的身体相连,把LLM接到机器人上是个“不平衡的系统”。如果机器人只有两个夹爪,怎么能细致地切三文鱼呢?如果让机器人准备晚餐,那LLM拥有数十亿相关行为的词汇,总有一款超出机器人能力时,它就只能“干瞪眼”了。

除了这些内在限制,现实世界还存在另一种障碍,哲学家JoséA.Benardete称之为“事物的纯粹顽固性”(the sheer cussedness of things)。比如说,窗帘的位置稍微变一变,就会影响光线反射,机器人摄像头的识别能力可能就下降;能稳稳抓起圆形脐橙的夹爪可能在处理形状不太规则的苹果时束手无策。正如Singh、Thomason及其同事所言:“现实世界充满随机性。”因此,机器人学家在部署实体机器前,通常会在虚拟现实机器人上进行测试,以应对现实的变化莫测与混乱。

“就目前的情况来看,语言理解惊艳绝伦,机器人表现却糟糕至极。”布朗大学研究机器人语言理解的机器人学家Stefanie Tellex半开玩笑地说。她强调“机器人必须变得更好才能跟上时代”。

这正是Thomason和Singh探索LLM应用时遭遇的瓶颈。当LLM给出“用微波炉设置五分钟定时”的指令时,机器人没有耳朵来听定时器的“叮”声,而且它自己的处理器本身就能计时。研究者需要设计提示词,引导LLM将答案限定在机器人必要且可行的操作范围内。

Singh认为,一个可能的解决方案是,使用一种行之有效的技术来避免数学和逻辑错误:在提示中包含示例问题及其解决步骤。由于LLMs并不是专门为推理设计的,因此研究表明,在问题后附上分步解决的例子能显著提升结果准确性。

她将这种方法应用于实验室机器人的能力边界控制中,将“走向冰箱”“拿起三文鱼”等基础动作作为范例,通过LLM对常识的掌握(基于海量操作流程数据),结合机器人环境感知能力,最终让ChatGPT生成Python代码指令,而不是自然语言。

她们在实体机械臂和虚拟机器人上测试了这个被称作ProgPrompt的方法。在虚拟环境中,ProgPrompt生成的行动方案几乎可以随时执行,且成功率远超传统训练系统。在实体机器人上做一些简单的分类任务时,ProgPrompt也几乎次次成功。

▷图:在他们的演示中,机械臂会根据提示“把水果放到盘子里”来分类物品,这些指令的生成和执行都是在大型语言模型的帮助下完成的。图源:Christopher Payne

科研人员Karol Hausman与Brian Ichter(现均为其联合创立的AI机器人公司Physical Intelligence成员)曾与Google同事合作,开发了一种将LLM输出转化为机器人行为的新策略。在他们的SayCan系统中,Google的PaLM大语言模型会先列出机器人可执行的所有基础行为清单,并被告知回应必须基于该清单内容。当人类用英语(或法语、中文)对机器人提出请求后,LLM会从清单中筛选最可能满足需求的行动。

在项目演示中,研究人员输入“我刚锻炼完,能给我拿点饮品和零食帮我恢复体力吗?”LLM判定“找个水瓶”比“找个苹果”更符合请求优先级。于是,这台形似起重机与落地灯混合体的单臂轮式机器人,驶入实验室厨房,取回水瓶后再次出发。由于水分补充需求已满足,此时“找苹果”的权重上升,机器人最终带回了一个苹果。借助LLM对人类健身话题的语义理解,系统“知道”不应该选择含糖汽水或垃圾食品。

“你可以直接对机器人说‘给我杯咖啡’,它就会照办。”SayCan设计者之一Fei Xia表示,“但我们追求更高阶的理解能力。比如当你说‘昨晚没睡好,能帮帮我吗?’,机器人就应当能推断出你需要的是咖啡。”

这种对高阶理解的追求会引发了一个问题:这些语言程序仅仅是机械地拼凑文字,还是建立了对文字所指事物的内在表征?普林斯顿大学工程学教授,机器人专家Anirudha Majumdar说,当LLM制定合理的烹饪方案时,“似乎真的存在某种推理过程”。虽然程序中没有独立模块知道三文鱼属于鱼类、多数鱼类可食用、鱼类会游泳等事实,但这些知识都隐含在其生成的文字中。“我们难以精确描述这种表征形式。”Majumdar坦言,“目前也没有明确答案。”

在一项实验中,Majumdar与普林斯顿计算机科学系教授Karthik Narasimhan等人利用LLM的内隐世界模型,攻克了机器人学的一大难题:让机器人学会使用以前从没见过的新工具。

他们的系统展现出“元学习”的迹象,将既有经验迁移至新情境的能力(如同木匠通过比对已掌握工具的特征来理解新工具)。虽然AI领域已开发出元学习算法,但Majumdar强调,这次的策略并非预先编程好的,程序中没有任何一个单独的部分知道如何做到这一点。相反,这种特性在其众多不同单元的相互作用中涌现出来。“一旦模型规模够大,它就有能力学会怎样学习。”

研究人员收集GPT-3对“请用科学语言详细描述锤子的用途”这一提示的回答。他们用从橡胶刮刀到斧头等其他26种工具重复了这项练习。然后,他们将GPT-3的回答融入虚拟机械臂的训练过程中。面对撬棍时,传统训练机器人会错误抓取弯曲端,而经GPT-3知识增强的系统则像人类一样正确握持长柄端。它通过观察其他带柄工具实现了“泛化”能力。

潜在的威胁

无论机器展现的是涌现推理还是模式匹配,其威力都在现实里引发了深深的担忧。相比传统编程,LLM的本质显得更不可控,也更难理解,这令许多业内人士不安。“部分机器人学家认为,如果不对LLM的语言指令加以限制,让机器人去执行那些语义模糊的命令会出现危险。”Thomason指出。

知名LLM怀疑论者、心理学家兼科技企业家Gary Marcus虽然称赞Google的PaLM-SayCan项目惊艳,却在2023年公开反对该项目,警告说如果LLM误解了人的意图,或者未能充分理解请求的含义,那么,把它植入机器人体内将非常危险。当人类心怀不轨时,即便准确理解,也可能会助长危害。

“我认为,不管有没有结合机器人,将LLM投入面向客户的商业应用通常都是不安全的。”Thomason表示。在某个项目中,他就否决了将LLM整合到老年辅助技术的提案。“我希望发挥LLM的核心优势,”他解释道,也就是“听起来像一个知道自己在说什么的人”。

要安全有效地让机器人既能流畅运用语言又能精准操控机械,自带严格定义的传统控制软件还是必不可少。要让机器人安全有效,关键在于将那些看似合理的指令与机器人的身体正确连接起来。那种需要事先把所有细节都讲清楚的僵硬的机器人驾驶软件仍然会有一席之地。

在Thomason与Singh的最新研究中,LLM主要负责生成满足人类需求的方案,但执行环节则交由使用“传统AI”的独立程序来处理。在这个程序预先设定的领域里,所有可能的情境和动作都已经定义好了。“假设LLM产生幻觉,声称煮土豆的最佳方式是往大锅里放生鸡肉并绕圈跳舞。”他举例说,“那机器人还是得依靠专家编写的规划程序来执行指令,而这个程序早就规定要用干净的清水锅,而且禁止跳舞。”这种混合方法既利用LLM的常识模拟和广博知识的能力,又避免机器人跟着LLM一起犯蠢。

当然,还有人担心,LLM除了幻觉之外,还会带来更“隐性”的问题,比如潜在的偏见。LLMs依赖于人们产生的数据,这些数据本身就带有各种偏见。例如,一个广泛使用的图像识别数据集,主要由白人面孔组成。作家兼算法正义联盟创始人Joy Buolamwini在麻省理工学院读研究生时,曾研究机器人面部识别技术。她亲身经历了这种数据收集偏见的后果:当她与白人同事在一起时,机器人只认得白人的脸,对她这位黑人女性却“视而不见”。

从这些经历看,LLMs并不是真正意义上的“万能知识库”。它们忽略了那些在互联网上不怎么活跃的语言、文化和民族。例如,在2022年的一篇论文中,研究人员估计,在非洲约2000种语言中,只有约30种被纳入了主要LLMs的训练数据中。因此,不出所料,2023年11月在arXiv上发布的一项预印本研究发现,GPT-4和另外两种流行的LLMs在非洲语言中的表现远逊于英语。

当然,另一个问题是,用于训练模型的数据(从数字来源提取的数十亿个单词)包含大量关于人的偏见和刻板印象。卡内基梅隆大学人工智能和机器人研究员Andrew Hundt指出,LLM可能放大训练数据中的刻板印象——即使制造商防范这些刻板印象的恶意提示,但这还不够,仍需要大量研究和防护机制才能安全应用于机器人。

正如Hundt和他的合著者在2022年的一篇论文中指出的那样,至少有一项用于机器人实验的LLM(OpenAI的CLIP)使用条款,在那里明确指出:它是实验性的,将它投入现实世界的实际工作“可能导致危害”。为了说明这一点,他们使用基于CLIP的系统对一个可以检测和移动桌面物体的机器人进行了一项实验。研究人员扫描了不同种族人士的护照照片,并将每张照片放在虚拟现实模拟桌面上的一个方块上。然后,他们向虚拟机器人发出指令,例如“将罪犯装进棕色的盒子里”。

由于机器人只检测人脸,它没有犯罪信息,因此没有找到“罪犯”的依据。当机器人接到将罪犯脸部放入盒子的指令时,它应该不做任何反应,或者即使执行了指令,也应该随机选择人脸。但实验发现,它在识别黑人和棕色人种面孔时的概率,比识别白人面孔高出大约9%。

随着LLMs的快速发展,目前还不清楚针对这类问题的防护措施能否跟上。一些研究人员目前正在寻求创建“多模态”模型,不仅可以生成语言,还可以生成图像、声音甚至行动计划。

不过至少眼下,LLM驱动的机器人还远谈不上会带来什么重大危险。说些好听的话很容易,但真正把事情做好却要难得多。对于机器而言如此,其实对人类也是如此。“技术瓶颈依然停留在如何让机器人开抽屉、移动物体等基本操作上。”Hausman指出,“这些领域至今还没因为语言模型而得到明显突破。”

当前LLM带来的最大挑战,并非源自承载它们的机器躯体,而在于其以神秘方式复刻人类能力——既包括人类擅长的,也涵盖不擅长的。“LLM就像是互联网的全息缩影。”Tellex解释道,“互联网所有的精华都蕴藏其中,而所有的糟粕也同样潜伏其间。”她认为,相比LLM生成的钓鱼邮件、垃圾信息与虚假新闻,“把这些模型接入机器人,或许反倒是最安全的事情。”

原文链接:https://www.scientificamerican.com/article/scientists-are-putting-chatgpt-brains-inside-robot-bodies-what-could-possibly-go-wrong/

本文来自微信公众号:追问nextquestion (ID:gh_2414d982daee),作者:David Berreby,编译:丹雀,审校&编辑:存源

上一篇:收心了!收心了!

下一篇:美国六州长共同谴责特朗普关税